Ich gehe hier nur grob auf den Aufwand ein. 30 Stunden – Trouble-Shooting inklusive. Angaben zum Aufwand – erledigt. Viiiiiielleicht – Wenn ich einmal Zeit habe erzähle ich die Geschicht vom Thomas, der auszog um seinem Rechner zweifelhafte Intelligenz zu verpassen. Aber da das ein ähnlicher Prozess war wie aus Pinocchio einen kleinen Jungen zu machen – Esel und Wahl inklusive – verfasle ich mich jetzt mal nicht.

Konkret hieß das aber einen ganz guten Computer der Sache zu opfern.

| HP VICTUS Gaming-PC | |

|---|---|

| Prozessor | AMD Ryzen 7 3700X 8-Core |

| Ram | 32 GByte |

| Festplatten | 1 TByte NVME 500 MByte SDD |

| Grafikkarte | Intel Graphics Nvidia GeForce 2060 Super 8G Ram |

Das Abenteuer beginnt

- Proxmox Hypervisor aufsetzen

- Proxmox tweaken

- In den Cluster integrieren

- Grafiktreiber für die Verwendung in Containern installieren

- Proxmox und den Rest nochmal aufsetzen…

- Es mit einer virtuellen Maschine probieren

- Proxmox und den Rest nochmal aufsetzen…

- Es mit einem Container probieren…

- den Treiber beim Troubleshooting zerstören

- Proxmox und den Rest…

- usw.

- Container erstellen

- privilegiert, 20GB Ram, 6 CPUs, 128Gb Festplatte

- Grafikkarte für Container verfügbar machen

- nvidia-container-toolkit nicht vergessen!

- Docker aufsetzen

- Docker compose

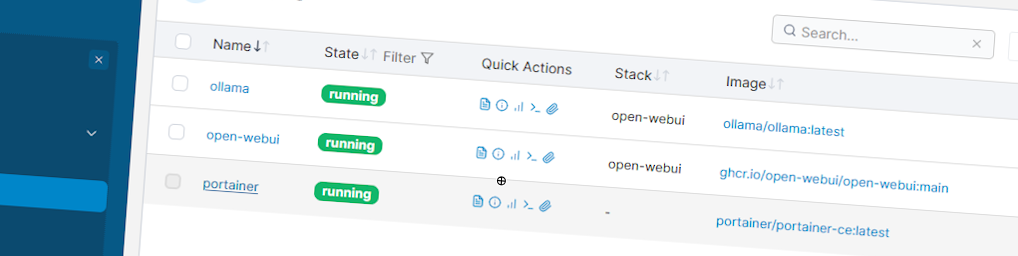

- Portainer

- Ollama aufsetzen

- Doku Lesen!

- Los-Chatten und verschiedene Modelle testen

Nachdem ich mir bei dem ganzen Vorgang von Chat-GPT helfen lies, muss ich sagen: Steile Lernkurve. Außerdem ist das nicht einfach ein Clicksy-Klaxi und es läuft schon, sondern eine Sache die immer Troubleshooting braucht, bevor es läuft.

Das Gelernte kommt mir bei anderen AIs sicher auch noch zu gute.

Und lohnt sich das?

Jain.

Eine AI mit vollem Funktionsumfang zu nutzen kostet im Moment etwa 20€ im Monat. Bing und Google und OpenAI etc. liegen da alle nahe beieinander. Ollama hilft mit einer Anzahl AI-Modellen und einer an GPT erinnernden Oberfläche Erfahrungen mit verschiedenen Modellen zu sammeln.

MIXTRAL etwa weiß scheinbar einfach alles. Und selbst wenn das Internet weg ist, hat man fast das gesamte Wissen verfügbar.

LLAVA kann als multimodale AI, Bilder ganz sinnvoll interpretieren.

Aber… Das Lama läuft langsam!! Auch wenn das Ergebnis inhaltlich OK ist – eine Anfrage die bei GPT in Sekunden beantwortet ist, kann auf meiner 800€-Hardware schon einige Minuten brauchen. Der Funktionsumfang kann kaum mit den multimodalen Fähigkeiten von GPT und Konsorten mithalten. Wenn man die Verarbeitungsgeschwindigkeit miteinbezieht lohnt sich eigenen Rechner dafür zu opfern, errechnetermaßen erst nach mehr als 10 Jahren.

Warum also?

Was ich in der einen Woche seit ich das Projekt gestartet habe gelernt habe, ist nicht zu bezahlen!

![bitspirit[d]uality](http://www.bitspirits.com/wp-content/uploads/2023/06/header_bitspidu-1024x293.png)